本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

打造一个自动驾驶控制系统需要多少个神经元?

MIT的科学家告诉你,最少只要19个!方法是向线虫这种初等生物学习。

最近,来自MIT CSAIL、维也纳工业大学、奥地利科技学院的团队已经开发了一种基于线虫大脑的新型AI系统。研究成果登上了最近的《自然·机器智能》杂志。

他们发现,具有19个控制神经元的单个算法,通过253个突触将32个封装的输入特征连接到输出,可以学习把高维输入映射到操纵命令。

这种新的AI系统用少量人工神经元控制车辆转向。而基于LSTM的神经网络打造同样的自动驾驶系统,网络结构则要复杂得多。

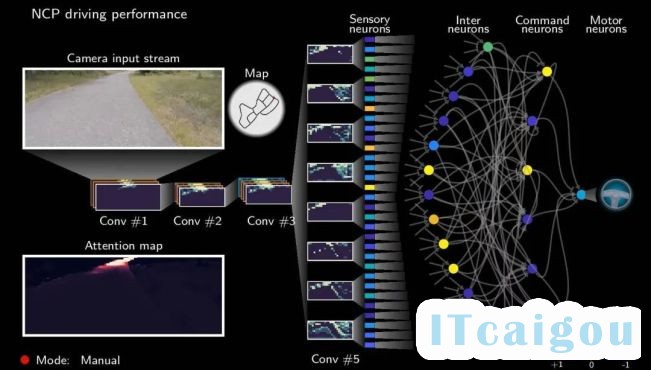

△实现的车辆控制系统

为何能做到这么少的神经元数量,论文共同一作MIT CSAIL博士后Ramin Hasani解释说:

与以前的深度学习模型相比,每个单元内信号的处理都遵循不同的数学原理。

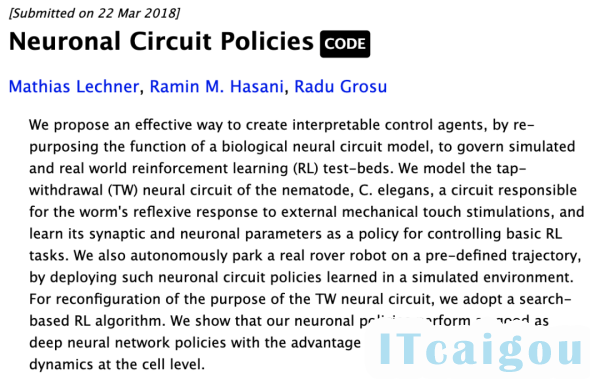

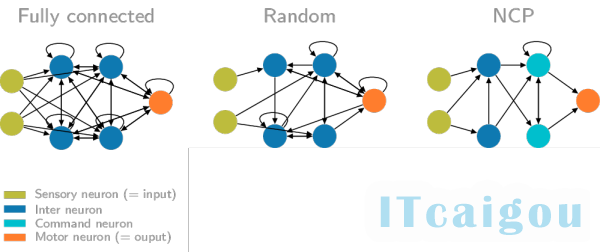

他们从秀丽隐杆线虫这种生物受到启发,在2018年提出了一种神经元回路策略(Neuronal Circuit Policies,NCP)。

NCP方法是重新利用生物神经回路模型的功能,创建可解释的控制智能体,管理虚拟和现实世界的强化学习(RL)测试平台。

该方法对线虫的TW神经回路进行建模,这个回路主要负责线虫对外部机械触摸刺激的反射反应,通过掌握其突触和神经元参数,作为控制基本强化学习任务的策略。

为了测试这种新的数学模型,团队选择了一项特别重要的测试任务——让自动驾驶汽车保持在车道上。神经网络接收摄像机拍摄的道路图像,然后自动决定是向左还是向右转。

诸如自动驾驶之类的复杂任务,往往需要具有数百万个参数的深度学习模型。但是,用NCP方法能够将网络规模减少两个数量级。

而这个19神经元极简自动驾驶系统仅使用了7.5万个训练参数,参数数量降低了2个数量级。

NCP方法构建的自动驾驶系统也需要,但是仅用于从摄像机传入的视觉数据,并从中提取出结构特征。它与车辆的实际转向无关。

后面的神经网络来确定摄像机图像的哪些部分重要,然后将信号传递到网络的NCP控制系统。

系统的控制部分将感知系统中的数据转换为转向命令,仅包含19个神经元。

两个子系统堆叠在一起并同时接受训练,训练数据集是波士顿地区人类驾驶汽车视频,包括图像与汽车转向操作的关联数据。

将它们一起输入网络,直到系统学会自动将图像与适当的转向系统连接起来,可以独立处理新情况。

除了结构简单外,用NCP设计的自动驾驶系统相比传统模型,还有两大优势:可解释性和鲁棒性。

系统的可解释性能让我们我们看到网络将注意力集中在什么方面。

从视频中可以看出,神经网络专注于图像的非常具体的部分,比如路边和地平线。研究人员表示,这种行为是在AI系统中是独一无二的。

此外,可解释性细化到了每个神经元。我们还能看到哪个神经元(视频中亮起部分)在驾驶决策中的作用。我们可以了解单个神经元的功能及其行为。

为了测试对比与传统模型和NCP模型的鲁棒性,研究人员还给输入图像加入了扰动,并评估了智能体对噪声的处理能力。结果NCP表现出了对输入伪像的强大抵抗力。

除了可解释性和鲁棒性,NCP模型还有其他优势。比如减少训练时间,减少在相对简单的系统中实现AI的不确定性。

Ramin Hasani博士还表示,NCP不仅能应用自动驾驶中,它能模仿学习意味着更广泛的应用,比如仓库的自动化机器人等等。