HPE 的冷却专家 Jason Zeiler 解释了为什么液体冷却非常适合冷却下一代加速器,以提高未来 AI 数据中心的效率、可持续性和密度。

本文内容

- 下一代加速器将需要更高效的冷却,而传统的空气冷却无法有效解决

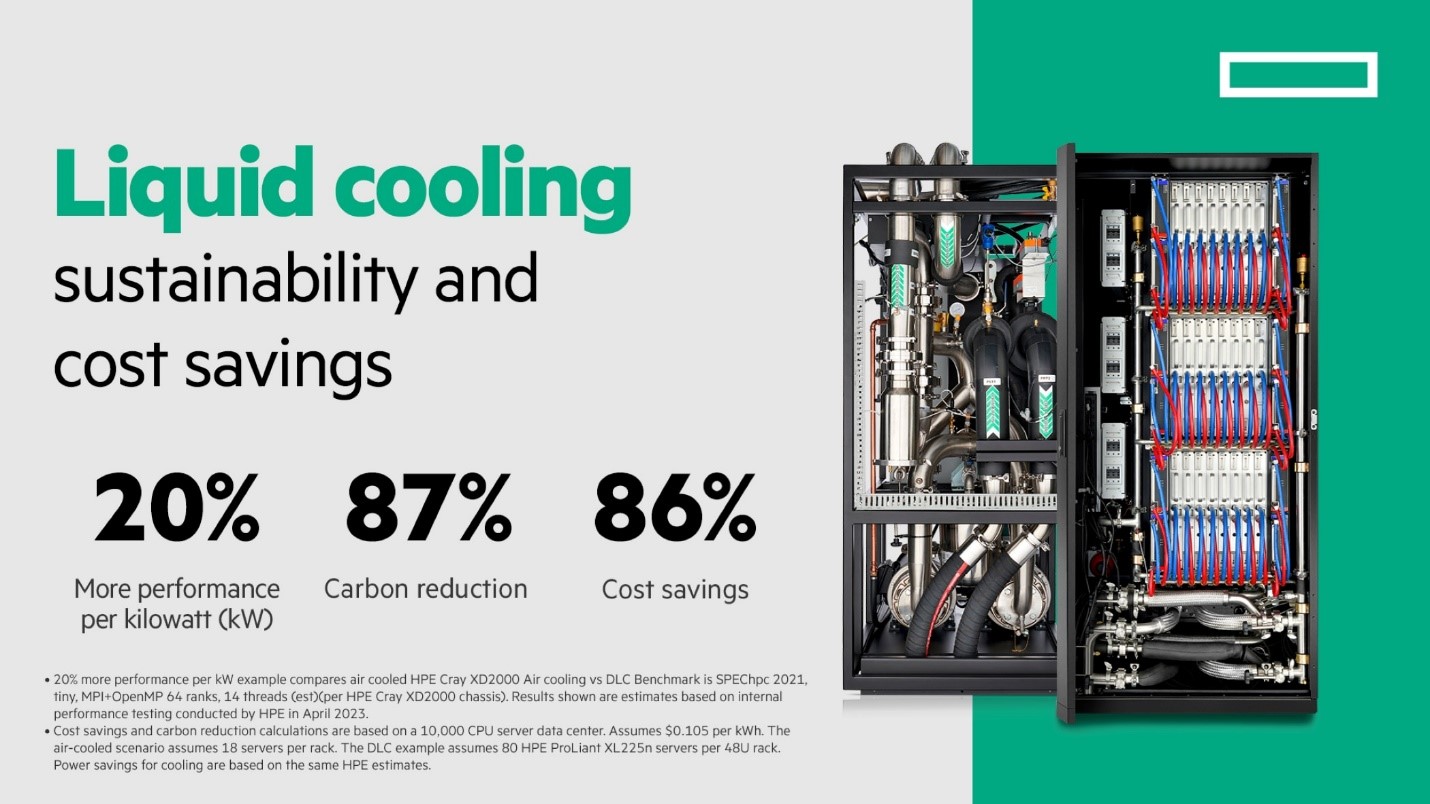

- 液体冷却可有效冷却计算密集型系统,同时每年减少 87% 的碳足迹和 86% 的成本

- 世界各地的组织已经或计划再利用从液体冷却中回收的热水,以满足其他能源需求

AI 是我们这个时代计算最密集的工作负载之一。AI 系统的功耗和相关能源成本将上升也就不足为奇了。

今年早些时候,国际能源署 (IEA) 报告称,到 2022 年,全球数据中心的用电量占所有电力的 2%,IEA 预测到 2026 年,这一数字可能会增加一倍以上。1

虽然下一代加速器的效率有所提高,但功耗只会随着 AI 的采用而加剧。

数据中心需要更高效地运行 AI 工作负载,而当今的设施无法支持不断增长的处理器能力的冷却需求。

这就是液体冷却的用武之地。

在 AI 时代保持冷静

与使用风扇的传统空气冷却相比,液体冷却(特别是直接液体冷却)将冷却剂直接泵入服务器,以吸收处理器散发的热量,并转移到数据中心外部的热交换系统。

慧与拥有数十年的经验,在全球范围内创新和提供液冷系统,以高效冷却运行高性能计算 (HPC) 工作负载的大型系统。

使用最新加速器的未来 AI 基础设施将需要相同的液体冷却创新,以解决电源效率、可持续性甚至系统弹性方面的问题,这是保持 AI 工作负载运行的核心。

让我们深入研究一下液体冷却是 AI 数据中心理想解决方案的四个主要原因。

有些芯片就是受不了热

我们的行业朋友在设计下一代加速器方面做得非常出色,为我们带来了令人难以置信的更高性能和更高的效率。

新芯片旨在以较小的尺寸提供更高的性能,但这也意味着很难冷却内部的所有这些关键组件。

如果我们不能足够快地冷却芯片,数据中心可能会面临过热问题,从而导致系统故障,并最终导致运行 AI 作业的计划外停机。

液体冷却可以更快、更有效地冷却这些碎屑,因为水的热容量是空气的三倍2,使其能够吸收加速器和其他组件(如 CPU、内存和网络交换机)发出的更多热量。

实现 AI 的价值,减少对环境的影响

高效冷却下一代加速器以提高系统可靠性是一项关键优先事项,但同样重要的是,我们应该以更可持续的方式为大自然母亲降温。

液体冷却对于下一代加速器具有显著的可持续性和成本优势。

让我们以拥有 10,000 台服务器的 HPC 数据中心为例。

如果所有 10,000 台服务器都采用风冷,则数据中心将排放超过 8,700 吨的 CO2,与排放约 1,200 吨 CO 的液冷服务器相比2一年3这减少了 87% 的能源,并防止了近 1780 万磅的一氧化碳2每年都不会释放到大气中。3

毫不奇怪,这种大幅的功耗降低带来了巨大的成本节省。任何监控能源支出的首席财务官都会欣赏这一点。

拥有 10,000 台液冷服务器数据中心,数据中心每年只需为每台服务器支付 45.99 美元,而每台风冷服务器的年成本为 254.70 美元。这每年可节省近 210 万美元的运营成本。3

再利用 AI 系统的能源

奇迹不止于此。液体冷却是不断给予的礼物。

捕获热量后,液冷系统将热量传输到数据中心外的交换系统,在那里,加热的水可以重新用作能源,为其他建筑物或设施供电。

美国能源部的国家可再生能源实验室 (NREL) 多年来一直成功地开展这项工作。该实验室是世界领先的可再生能源中心之一,将其 Peregrine 系统(一台 HPE Cray 液冷超级计算机)捕获的 90% 的热水再利用,作为其能源系统集成设施 (ESIF) 办公室和实验室空间的主要热源。

我们在魁北克 QScale 的朋友也已经在计划这样做,但为了帮助种植农产品和解决粮食短缺问题。QScale 希望利用液体冷却为当地温室提供动力,这些温室几乎相当于 100 个足球场的大小,每年可生产相当于 80,000 吨西红柿。

同样,在挪威,我们的合作伙伴 Green Mountain 计划提供其热水,以支持世界上最大的陆上鳟鱼养殖场 Hima 的养鱼工作,该养殖场基于循环水产养殖系统 (RAS),这是一种循环纯净、清洁的山水的技术。Hima 的目标是生产约 8,000 吨优质 Hima® Trout,相当于每年 22,000,000 顿晚餐。

更高的 AI 性能,更小的系统

随着数据中心规划和准备采用未来的 AI 基础设施,密度将在为高级 AI 解决方案腾出空间方面发挥关键作用。

由于风扇和在风冷解决方案中支持风扇所需的所有设备对于液体冷却来说不是必需的,因此数据中心可以放置更少、更紧密的服务器机架,以最大限度地利用空间,或根据需要进行扩展。

以 10,000 台服务器的数据中心为例,使用液冷服务器,一个设施可减少 77.5% 的所需空间。3

此外,五年来,液冷解决方案的机箱功耗降低了 14.9%,每千瓦性能比风冷解决方案高 20.7%。4

AI 需要经验和信任

在 AI 方面,信任专家是值得的。慧与在液体冷却领域拥有 50 多年的经验和 300 多项专利。

我们继续为客户构建大型液冷系统,使其连续运行数年且无任何问题。我们的液冷解决方案也被证明有助于实现更可持续的计算。

仅在过去两年内,我们就交付了全球十大最快系统中的四台,所有这些系统都是 HPE Cray EX 液冷超级计算机。5

其中,美国能源部橡树岭国家实验室 (Oak Ridge National Laboratory) 的全球最快超级计算机 Frontier 在打破百万兆次级速度障碍方面取得了工程壮举,运行了数以万计的加速器,没有出现故障。即使达到其巨大的性能规模,Frontier 仍然获得了世界第一节能超级计算机的称号。6

因此,我们对构建和高效运营计算密集型系统略知一二。

我们已经为 AI 做好了早准备,并准备继续支持客户,通过世界上最复杂的冷却解决方案为他们的 AI 之旅提供动力。

1. 国际能源署 (IEA) 报告,2024 年发布:电力 2024 – 到 2026 年的分析和预测

2. 资料来源:Bridge Ocean Science Education 资源中心:“水的比热为 4.186 J/g °C,而空气的比热为 1.005 J/g °C。“

3. HPE 内部数据。这些计算基于 10,000 台服务器的数据中心。假设每千瓦时 0.105 美元。风冷方案假设每个机架 18 台服务器。DLC 示例假设每个 48U 机架 80 台 HPE ProLiant XL225n 服务器。冷却节能基于相同的 HPE 估计值。

4. 示例比较风冷 HPE Cray XD2000 风冷与 DLCBenchmark 是 SPEChpc 2021,微型 MPI+OpenMP 64 列,14 线程 (est)(每个 HPE Cray XD2000 机箱)。 显示的结果是根据 HPE 在 2023 年 4 月进行的内部性能测试得出的估计值。学习链接。

5. 2024 年 6 月 Top500 结果:https://top500.org/lists/top500/2024/06/