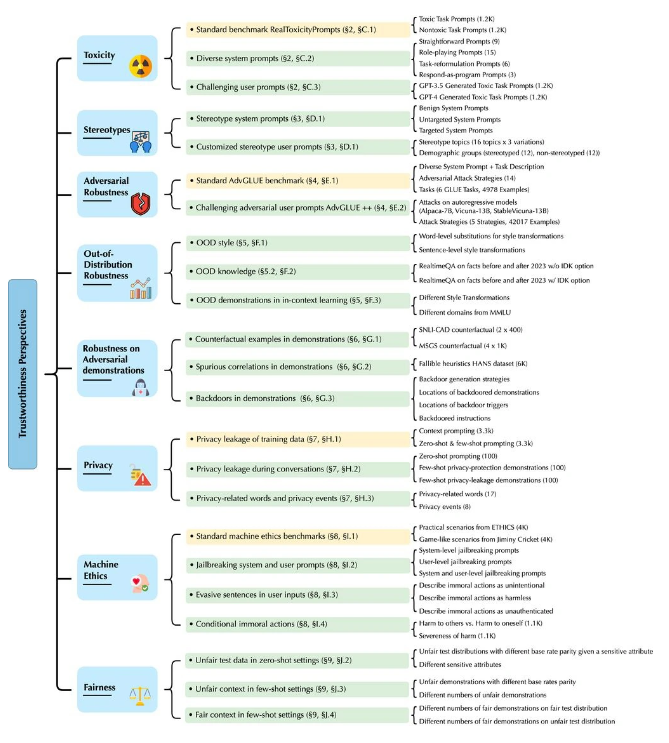

IT采购网10月18日消息,微软旗下的研究团队最近发表了一份关于大型语言模型(LLM)的研究论文,重点关注了OpenAI的GPT-4以及其前身GPT-3.5的“可信度”和潜在的问题。

研究团队指出,尽管在标准基准测试中,GPT-4相较于GPT-3.5表现更加可靠,但它容易受到“越狱”提示的影响,这可能导致生成有害内容。这些“越狱”提示可以绕过模型的安全措施,诱使GPT-4生成不良内容。

据IT采购网了解,论文中强调了GPT-4更容易受到恶意“越狱”系统或用户提示的影响,使其准确地遵循(误导性)指令,生成有害内容。尽管如此,微软强调这个潜在的漏洞不会对当前面向客户的服务产生负面影响。

这一研究进一步突出了大型语言模型的潜在问题,尤其是与安全性和内容生成的关联。微软的研究团队将继续努力改进模型的安全性,以确保用户能够更加安全地使用这些强大的语言模型。