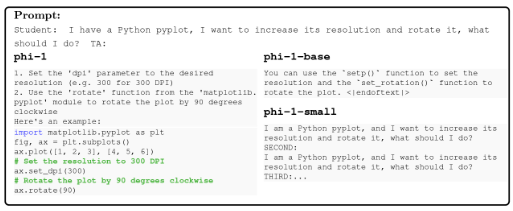

IT采购网6月27日消息,据了解,微软近日发布了一款名为phi-1的语言模型,该模型拥有13亿参数。与传统认知不同的是,该模型证明了模型参数的数量并不是决定性因素,更重要的是训练数据的质量。phi-1采用了高品质的数据集进行训练,包括网络上的教科书级别数据以及经过逻辑严谨处理的内容,训练过程只用了短短的4天时间。

微软团队表示,相较于增加模型的参数量,提高训练数据集的质量或许能更有效地提升模型的准确性和效能。通过这一理念,他们成功地训练出了phi-1模型。在测试中,phi-1取得了50.6%的分数,表现优于拥有1750亿参数的GPT3.5(47%)。

微软还表示,phi-1模型将在HuggingFace平台上进行开源。值得一提的是,这不是微软首次开发小型语言模型,此前他们已经推出了一款拥有130亿参数的Orca模型,该模型采用了GPT-4合成的数据进行训练,并且表现也优于ChatGPT等模型。

目前,phi-1的相关论文已经发布在arXiv上,感兴趣的读者可以在该平台上找到论文的详细内容。微软的这一研究成果引起了广泛的关注,为未来语言模型的发展带来了新的思路和可能性。