机器学习算法已成为一项重要的网络安全技术,目前它主要用于识别恶意软件、将经过筛选的警告呈现在安全分析员面前,以及确定漏洞优先级以打上补丁。研究机器学习和人工智能系统安全的专家警告称,未来这类系统可能被专业的攻击者所利用。

研究人员在去年发表的一篇研究论文中表示,神经网络的冗余特性可以让攻击者将数据隐藏在常见的神经网络文件中,占文件20%的大小,而不显著影响模型的性能。2019年的另一篇论文表明,受感染的训练服务可能会在神经网络中植入实际持续存在的后门,即使该网络接受训练以处理其他任务。

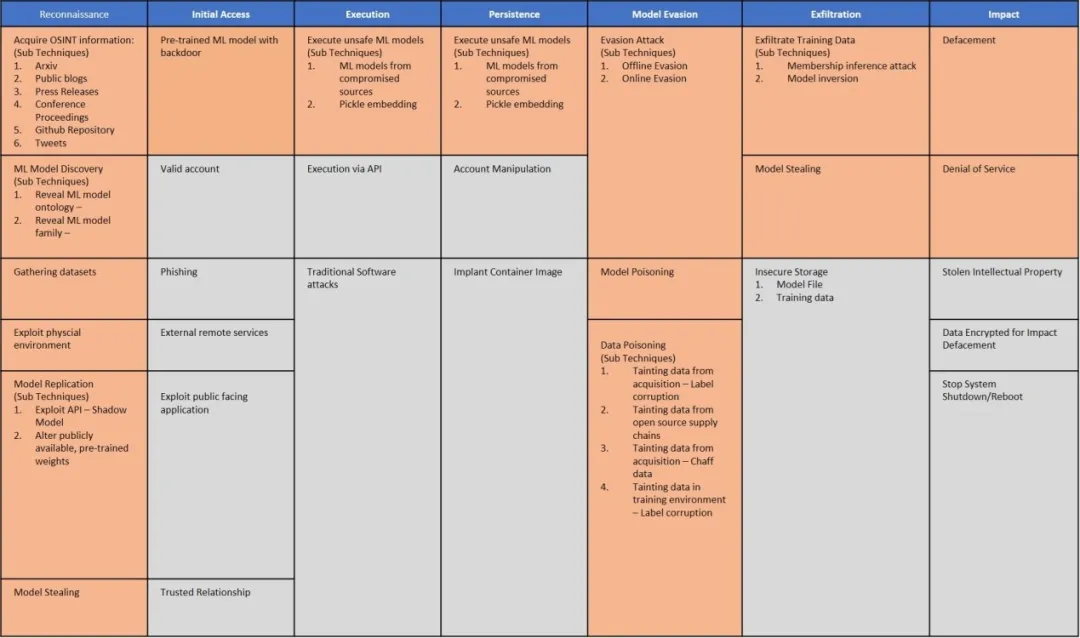

图1 《对抗性机器学习威胁矩阵》

来源:MITRE

贝里维尔机器学习研究所(BIML)联合创始人兼首席执行官Gary McGraw表示,这两篇研究论文表明了机器学习存在的潜在威胁,但最直接的风险还是窃取或篡改数据的攻击。他表示:“如果将机密信息放入机器中,并让机器学习该数据,人们会忘了机器中仍然存在机密信息,忘了会有一些更高明的手法可以取出信息。开发人员通常只专注于为该技术创造新用途,而忽略了其开发产品的安全性时,这种潜在威胁有时会更严重。”

2020年,微软、MITRE等公司联合发布了一份列出潜在攻击清单的报告——《对抗性机器学习威胁矩阵》(Adversarial ML Threat Matrix)。报告称,企业需要评估依赖人工智能或机器学习技术的系统是否存在潜在风险。一些风险(比如将数据隐藏在机器学习文件中)与日常风险没多大不同。除非企业测试系统具有弹性,否则更多针对机器学习的风险会大获成功,比如有可能创建这样的模型:攻击者触发后,能够以特定的方式行动。

软件安全公司Sophos的首席科学家Joshua Saxe表示,造成这种后果的原因是防御者只专注于眼前的攻击,而不是专注于那些未来且难以实施的复杂攻击。随着更多的安全专业人员依赖机器学习系统来完成工作,能够意识到这种威胁形势将变得更重要。研究人员创建的对抗性攻击矩阵包括规避检测恶意软件和控制流量、僵尸网络域生成算法(DGA)以及恶意软件二进制文件的工具。

McGraw指出,随着机器学习的应用,数据面临更大的风险。因为敏感数据常常可以从机器学习系统中恢复,同时,通过机器学习生成的系统又常常以不安全的方式运行。如果对机器学习系统执行的查询被暴露后,数据在操作过程中也会暴露,这突显了机器学习一个至关重要但未予以强调的方面,即确保数据安全非常重要。

Saxe表示,机器学习威胁有别于攻击者使用人工智能/机器学习技术来策划更有效的攻击。机器学习攻击可能会更多地在机器人和自动驾驶汽车领域发生,因为它们不仅依赖算法来操作,还将人工智能决策转化成实际动作,安全人员需要阻止和防范破坏这些算法的行为。

虽然研究人员表明了多种类型机器学习攻击的可能性比较大,但大多数仍在数年后才会出现,因为攻击者的工具箱中仍有简单得多的工具照样可以帮助其实现攻击目的。

参考链接:

https://www.darkreading.com/vulnerabilities-threats/machine-learning-in-2022-data-threats-and-backdoors-